谷歌(Google)DeepMind日前发布离线机器人AI模型Gemini Robotics On-Device,可在机器人本地直接运行,无需云端连接即可同时完成视觉识别、语言理解与动作执行,实时响应人类指令。

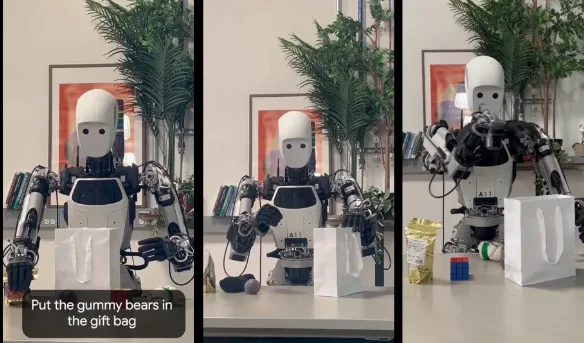

该模型采用视觉-语言-动作(VLA)基础架构,为双臂机器人量身定制,能解析自然语言指令并驱动机械臂执行折叠衣物、装配等复杂操作,通过50至100次示范即可快速学习新任务。

本地部署优势在于规避网络延迟与中断风险,尤其适用于对实时性和稳定性要求极高的医疗操作、灾难救援及工厂自动化场景,确保任务持续可靠执行。

模型最初在Aloha机器人系统上训练,后成功移植到Franka Emika FR3双臂机器人及Apptronik Apollo人形机器人,并在未知物体与新环境下展现出出色泛化能力。

谷歌同时推出Gemini Robotics SDK,开发者可借助MuJoCo模拟器结合少量示范对模型进行微调。目前该SDK与On-Device模型仅向受信任测试者提供,产业化应用处于私有预览阶段。

该离线模型基于Gemini 2.0架构,尚未集成最新Gemini 2.5特性,但已与英伟达(NVIDIA)Isaac GR00T、OpenAI RT-2等同级竞品形成正面竞争。